gradient conjugué

Comme précédemment, les nouvelles coordonnées sont obtenues à partir de l'équation (1). Le calcul du pas d'intégration et la première direction de recherche sont aussi pris comme précédemment. Ensuite, les directions de recherche seront choisies de sorte qu'elles soient conjuguées à leurs directions de recherche précédentes. Pour obtenir k conjugué à k-1, il faut exprimer k sous la forme d'une combinaison linéaire des directions du gradient à l'étape k et à l'étape (k-1).

équation (3)

\(\overrightarrow{D_k}=-\nabla\overrightarrow{F(r_k)}+ \frac{\left \| \nabla\overrightarrow{F(r_k)}\right \|^{2}}{\left \| \nabla\overrightarrow{F(r_{k-1})}\right \|^{2}}\)

Avantages :

Demande peu de ressource mémoire

Directions de recherche optimisées, converge mieux que SD au niveau du minimum.

Inconvénients :

plus d'étapes que les méthodes à dérivé seconde

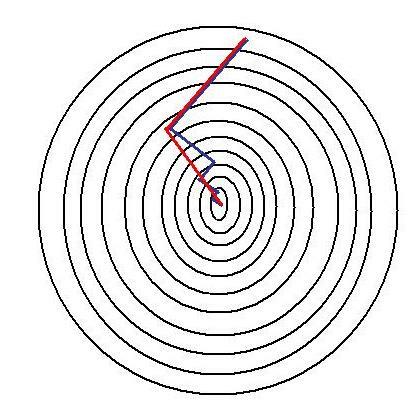

Comparaison des étapes entre Steepest Descent et le gradient conjugué :

vert : SD ; rouge : GC

Dû à sa direction de recherche optimisée, on voit que le gradient conjugué ne met que 2 étapes pour trouver le minimum alors que le SD a besoin 5 étapes.